ये AI की दुनिया है और हम बस इसमें रह रहे हैं.

इस नए AI युग का बिगुल बहुत पहले ही बज गया था. इसके आने का ऐलान भी हर जगह हो गया था. हालांकि, 2025 में ही फ़ैक्ट-चेकिंग आउटलेट्स ने कम से कम भारत में आखिरकार ग़लत जानकारी के सबसे नए ‘स्कूल’ (AI से बने कंटेंट और डीपफ़ेक) का सीधा सामना किया.

जैसे-जैसे जेनरेटिव AI (Gen AI) टूल्स, खासकर बड़े लैंग्वेज मॉडल (LLM) जो इंसानों जैसा टेक्स्ट, कोड, और इमेज/ऑडियो/वीडियो बनाने के लिए डिज़ाइन किए गए हैं, आम लोगों के लिए ज़्यादा सुलभ होते जा रहे हैं. AI से बना कंटेंट अब ‘खास’ नहीं रह गया है. अनगिनत जानकारी के इस दौर में AI ग़लत जानकारी फैलाने के सबसे महत्वपूर्ण टूल्स में से एक के रूप में सामने आया है. फ़ैक्ट-चेकर्स के लिए ये एक नई चुनौती है.

2025 में ऑल्ट न्यूज़ ने 39 AI-जेनरेटेड वीडियोज़ या तस्वीरों का फ़ैक्ट-चेक किया था. उनमें से 10 मामलों में राजनीतिक पार्टियां, राजनेता या मीडिया ऐसे कंटेंट को असली बताकर सक्रिय रूप से फैला रहे थे. इन सारी चहलपहल के बावजूद, 2024 में केवल सात AI-जेनरेटेड इमेज या वीडियोज़ सामने आए थे जो भारतीय संदर्भ में इतने महत्वपूर्ण थे कि ऑल्ट न्यूज़ को उनका फ़ैक्ट-चेक करना पड़ा. तो, इसके अलगे साल, ऐसे फ़ैक्ट-चेक्स में 457% की चौंकाने वाली बढ़ोतरी देखी गई.

जो इन्फ्लुएंसर, ऑथेंटिसिटी से ज़्यादा विज़िबिलिटी और एंगेजमेंट को प्राथमिकता देते हैं, उनके हाथों में जेनरेटिव AI एक जादुई छड़ी है. शाहरुख खान के साथ एक तस्वीर चाहिए लेकिन उनसे मिलने का मौका नहीं मिला? ChatGPT ये सपना सच कर सकता है. बचपन के किसी हीरो के साथ फोटो चाहिए जिसकी मौत हो चुकी है? ‘नैनो बनाना प्रो’ आपके लिए ये कर देगा. कल एक पेपर जमा करना है जिसे आपने अभी तक शुरू भी नहीं किया है? चिंता न करें, परप्लेक्सिटी आपके साथ है.

लेकिन इसका एक दूसरा पहलू भी है और ये काफी साफ़ है.

मशहूर डॉक्यूमेंट्री, ‘द एसेंट ऑफ़ मैन’ में जैकब ब्रोनोव्स्की ने इंसानियत को याद दिलाया था कि टेक्नोलॉजी का इस्तेमाल समझदारी और नैतिक दूरदर्शिता के साथ करना चाहिए. AI का मामला भी अलग नहीं है. जैसे-जैसे ये ज़्यादा से ज़्यादा आम होता जा रहा है, इसके बिना समझदारी और नैतिक दूरदर्शिता के इस्तेमाल होने की संभावनाएं बढ़ती जा रही हैं. इसका नतीजा 2025 में सबके सामने था.

AI वीडियो का इस्तेमाल सांप्रदायिक नैरेटिव को बढ़ावा देने के लिए किया गया

पिछले साल AI के ग़लत इस्तेमाल का सबसे बड़ा उदाहरण ये था कि BJP असम के सोशल मीडिया हैंडल ने मुसलमानों को निशाना बनाते हुए सांप्रदायिक प्रॉपगेंडा फ़ैलाया.

उदाहरण के लिए, 15 सितंबर को बीजेपी असम के X अकाउंट ने एक AI-जेनरेटेड वीडियो शेयर किया जिसमें “BJP के बिना असम” की एक झलक दिखाई गई थी. ये वीडियो कांग्रेस और उसके नेता गौरव गोगोई को निशाना बनाने के लिए था जिसमें AI फ़ुटेज में मुस्लिम “घुसपैठियों” को राज्य में घुसते और सरकारी ज़मीन पर कब्ज़ा करते हुए दिखाया गया था; टोपी, दाढ़ी और लुंगी पहने हुए आदमी सड़क किनारे बीफ़ काट रहे थे, जबकि मुस्लिम पुरुष और बुर्का पहनी महिलाएं राज्य के चाय बागानों और गुवाहाटी एयरपोर्ट, थीम पार्क, चिड़ियाघर, स्टेडियम और शहर जैसी सार्वजनिक जगहों पर भीड़ लगाए हुई थीं.

31 सेकंड का ये ‘विज्ञापन’ इस चेतावनी के साथ ख़त्म हुआ कि BJP के बिना, असम में 90% मुस्लिम आबादी होगी. इसमें कहा गया, “अपना वोट ध्यान से चुनें.” कैप्शन में लिखा था, “हम पाईजान के इस सपने को सच नहीं होने दे सकते.”

कई तरफ से कड़ी आलोचना और FIR दर्ज़ होने के बाद, असम BJP ने आखिरकार वीडियो डिलीट कर दिया, लेकिन तब तक उसे करीब 5 मिलियन व्यूज़ मिले थे. इस बारे में ऑल्ट न्यूज़ की 13 अक्टूबर को पब्लिश हुई डिटेल्ड रिपोर्ट यहां पढ़िए.

दिसंबर 2025 में BJP बंगाल और BJP दिल्ली ने भी ऐसा ही किया. राज्य में चल रही SIR प्रक्रिया का बहाना बनाकर, उन्होंने AI-जनरेटेड वीडियो शेयर किए जो खुलेआम सांप्रदायिक थे. एक वीडियो में मशहूर बंगाली काल्पनिक किरदार, गोपी और बाघा को आने वाले समय के कोलकाता में दिखाया गया जिसमें सभी साइनबोर्ड उर्दू में लिखे थे और सड़कों पर सिर्फ़ मुस्लिम समुदाय के लोग चल रहे थे. दूसरे वीडियो में AI-जनरेटेड क्लिप में मुसलमानों की तुलना कीड़ों से की गई जिसमें उन्हें मच्छर भगाने वाली कॉइल से भगाते हुए दिखाया गया.

यहां हमारी रिपोर्ट है कि कैसे SIR के बारे में लोगों को जागरूक करने की आड़ में पार्टी के सोशल मीडिया हैंडल ने खुलेआम सांप्रदायिक स्टीरियोटाइपिंग, डर फ़ैलाने और इस्लामोफ़ोबिया का सहारा लिया.

हालांकि, इनमें से कई वीडियोज़ काल्पनिक थे. सितंबर में एक ज़्यादा मुश्किल करनेवाला मामला सामने आया जब राहुल गांधी की एक महिला के साथ काले चश्मे पहने हुए ‘एकदम असली दिखने वाली तस्वीर’ ऑनलाइन शेयर की जाने लगी. कई X यूज़र्स ने दावा किया कि वो महिला उनकी पार्टनर थी. हमारी जांच में वायरल तस्वीर में कई गड़बड़ियां मिलीं. ऐसा लगा कि ये फ़ोटो 2000 के दशक की शुरुआत की एक तस्वीर पर आधारित थी जिसमें राहुल गांधी, चश्मे और काले कपड़े पहनी एक महिला के साथ बैठे हुए थे. बाद में उस महिला की पहचान वेरोनिक कार्टेली के रूप में हुई थी. उस पुरानी तस्वीर का इस्तेमाल कर हाल में एक तस्वीर AI की मदद से बनाई गई थी.

हालांकि, वायरल तस्वीर में राहुल गांधी काफी बूढ़े दिख रहे थे, लेकिन महिला नहीं – मुख्य रूप से इसलिए क्योंकि वेरोनिक की कोई दूसरी सार्वजनिक रूप से उपलब्ध तस्वीरें नहीं हैं जिससे पता चल सके कि वो उम्र के साथ कैसी दिखती होंगी. इससे दोनों तस्वीरों में काफी समानताएं दिखीं जिसमें उनके कपड़े और चश्मे भी शामिल है.

आखिरी पुष्टि तब हुई जब हम उसी रेफरेंस तस्वीर का इस्तेमाल करके खुद एक वैसी ही तस्वीर बनाने में कामयाब रहे जिससे ये साबित हुआ कि वायरल तस्वीर को आर्टिफ़िशियली बनाया गया था. इस मामले पर हमारी फ़ैक्ट-चेक रिपोर्ट यहां पढ़ सकते हैं.

Sweet couple ❣️

Daughter of drug lord with Pappu pic.twitter.com/1wbrlp8SZg

— Boiled Anda (@AmitLeliSlayer) September 8, 2025

राजनीतिक पार्टियों ने अक्सर इसी तरह की ग़लत जानकारियों का इस्तेमाल किया है. दिल्ली विधानसभा चुनावों से पहले, आम आदमी पार्टी (AAP) ने जनवरी में अपने सोशल मीडिया चैनलों पर एक वीडियो शेयर किया था जिसमें दावा किया गया था कि ये सेंट्रल विस्टा प्रोजेक्ट के हिस्से के तौर पर प्रधानमंत्री नरेंद्र मोदी का “शाही महल” या नया घर है. वीडियो में शानदार इंटीरियर, झूमर और लग्जरी चीजें दिखाई दे रही थीं और कैप्शन में ऐसा दिखाया गया था कि ये इस कथित घर की पहली झलक है. ऑल्ट न्यूज़ को लाइटिंग, इंटीरियर और चीज़ों में कई विज़ुअल्स में कई गड़बड़ियां मिलीं. इससे पता चला कि वायरल क्लिप AI से बनाई गई थी या उसमें बदलाव किया गया था. वीडियो में “सोरा” (OpenAI का एक वीडियो बनाने वाला टूल) का वॉटरमार्क भी दिख रहा था जो AI की मदद से कंटेन्ट क्रियेट करता है.

Big Breaking 🚨🔥

राजमहल का Video पहली बार आया जनता के सामने‼️😳

क्या इसलिए ही राजमहल के दरवाज़े जनता के लिए नहीं खोले जाते? pic.twitter.com/P52Ph2ak9n

— AAP (@AamAadmiParty) January 27, 2025

AAP के इस वीडियो पर ऑल्ट न्यूज़ की फ़ैक्ट-चेक रिपोर्ट पढ़ सकते हैं.

फिर, जुलाई में सोशल मीडिया पर एक वीडियो सर्कुलेट हुआ जिसमें दावा किया गया कि पाकिस्तान पीपल्स पार्टी (PPP) के चेयरमैन बिलावल भुट्टो जरदारी ने कहा था कि “हमारे लोग भारत की संसद में बैठे हैं.” ये क्लिप असम के मंत्री जयंत मल्लाबरुआ सहित कई भारतीय हस्तियों ने शेयर की थी और बाद में केंद्रीय मंत्री किरेन रिजिजू ने इसका ज़िक्र किया और BJP प्रवक्ता जयवीर शेरगिल ने विपक्षी नेताओं को निशाना बनाने के लिए इसे कोट किया. ऑल्ट न्यूज़ ने पाया कि वायरल वीडियो में ऑडियो के साथ छेड़छाड़ की गई थी — ये बिलावल के असली भाषण से मेल नहीं खाता था, और उनके होंठों की हरकतें क्लिप के शब्दों के साथ सिंक में नहीं थीं जिससे पता चलता है कि ये AI-जनरेटेड कंटेंट था.

We can deliver our propaganda in front of the Indian Prime Minister. Our agents are sitting in their parliament. Who is a Pakistani leader Bilawal Bhutto referring to? Is he from Assam? pic.twitter.com/dbAHSFTgBa

— Jayanta Mallabaruah (@jayanta_malla) July 31, 2025

हाल ही में बीजेपी के अनऑफ़िशियल IT सेल ने एक वीडियो बड़े पैमाने पर शेयर किया जिसमें कथित तौर पर एक मुस्लिम आदमी नाले के पानी से खाना बनाते हुए दिख रहा था. जितेंद्र प्रताप सिंह (@jpsin1) जैसे X यूज़र्स जो नियमित रूप से सांप्रदायिक प्रॉपगेंडा शेयर करते हैं और जिन्हें प्रधानमंत्री नरेंद्र मोदी भी फ़ॉलो करते हैं, उन्होंने इस वीडियो को खुलेआम सांप्रदायिक टिप्पणियों के साथ फैलाया. कई यूज़र्स ने इसे सच मान लिया और अपनी नफ़रत ज़ाहिर की. हालांकि, ऑल्ट न्यूज़ ने पाया कि ये वीडियो भी AI-जनरेटेड था. क्लिप में कई ऐसे फ़ैक्टर हैं जो वीडियो की सच्चाई पर शक पैदा करते हैं, लेकिन जब हम किसी बात पर विश्वास करना चाहते हैं तो हमारा कन्फर्मेशन बायस अक्सर हमें उन साफ संकेतों को नज़रअंदाज़ करने पर मजबूर कर देता है.

मुस्लिम होटल में लजीज बिरियानी खाने के शौकीन के लिए बहुत ही आंख खोलने वाली घटना है।

साफ सफाई का स्पेशल व्यवस्था इनके होटल में मिलेगी ही मिलेगी। चाहे कितने भी बड़े होटल हो या फिर सड़कों पर लगाने वाले बिरयानी ठेले के। भाईचारा निभाने के चक्कर में इन होटल में जाकर बिरयानी खाने वाले… pic.twitter.com/7IY0b4HbJn

— 🇮🇳Jitendra pratap singh🇮🇳 (@jpsin1) December 19, 2025

मीडिया द्वारा AI-जनरेटेड कंटेंट चलाने के मामले

मेनस्ट्रीम मीडिया भी कई बार AI-जनरेटेड कंटेंट के झांसे में आ चुका है. दिसंबर में इंडिया टुडे, हिंदुस्तान टाइम्स, ABP न्यूज़, आज तक, दैनिक भास्कर, News18 और ज़ी न्यूज़ सहित कई आउटलेट्स ने एक डिजिटल रूप से बदले गए वीडियो क्लिप पर आधारित रिपोर्ट चलाई जिसमें कथित तौर पर पाकिस्तान के पूर्व प्रधानमंत्री इमरान खान की बहन अलीमा खानम को पाकिस्तान सेना प्रमुख आसिम मुनीर को “कट्टरपंथी इस्लामी” कहते हुए दिखाया गया था और आरोप लगाया गया था कि उन्होंने भारत के साथ संघर्ष करवाया जो सोशल मीडिया पर वायरल हो गया था.

हालांकि, ऑल्ट न्यूज़ की जांच में पाया गया कि वीडियो को AI-जनरेटेड ऑडियो और बदले हुए लिप-सिंकिंग के साथ डिजिटल रूप से मैनिपुलेट किया गया था. स्काई न्यूज़ पर खानम के मूल इंटरव्यू में मुनीर की विचारधारा या भारत-पाकिस्तान संघर्ष के बारे में कोई बयान शामिल नहीं था.

एक और मामले में एक मॉर्फ्ड फ़ोटो वायरल हुई जिसमें दिल्ली की मुख्यमंत्री रेखा गुप्ता पर अगस्त में हमला करने वाला आदमी, आम आदमी पार्टी (AAP) के विधायक गोपाल इटालिया के बगल में खड़ा दिख रहा था और इसे रिपब्लिक भारत, आज तक और पंजाब केसरी जैसे न्यूज़ आउटलेट्स ने चलाया.

ऑल्ट न्यूज़ ने पाया कि ये तस्वीर डिजिटल रूप से बदली गई थी. इटालिया की तस्वीर असल में उनके एक पुराने वीडियो का स्क्रीनग्रैब थी जिसमें आरोपी नहीं था.

जून में एक वीडियो क्लिप वायरल हुई थी जिसमें एक शेरनी रात में सड़क पर चलते हुए एक आदमी को सूंघ रही थी जो सड़क किनारे सो रहा था, जिससे लगा कि वो बाल-बाल हमले से बच गया. इस फ़ुटेज को रिपब्लिक और न्यूज़18 जैसे मेनस्ट्रीम न्यूज़ आउटलेट्स ने दिखाया जिन्होंने शुरू में इस घटना को भारत में असली बताया और इसे एक डरावना अनुभव बताया.

हालांकि, ऑल्ट न्यूज़ ने पाया कि ये वीडियो AI से बनाया गया था. वीडियो में कई विज़ुअल्स में गड़बड़ियां थीं, जैसे पास की दुकानों के साइन पर अजीब टेक्स्ट और शरीर का अजीब पोस्चर. रिवर्स सर्च से ये फ़ुटेज एक यूट्यूब चैनल पर भी मिला जिसमें साफ तौर पर बताया गया था कि ये कंटेंट डिजिटल रूप से बनाया गया है. ऑनलाइन आलोचना होने के बाद रिपब्लिक और न्यूज़18 दोनों ने बाद में अपने आर्टिकल अपडेट किए.

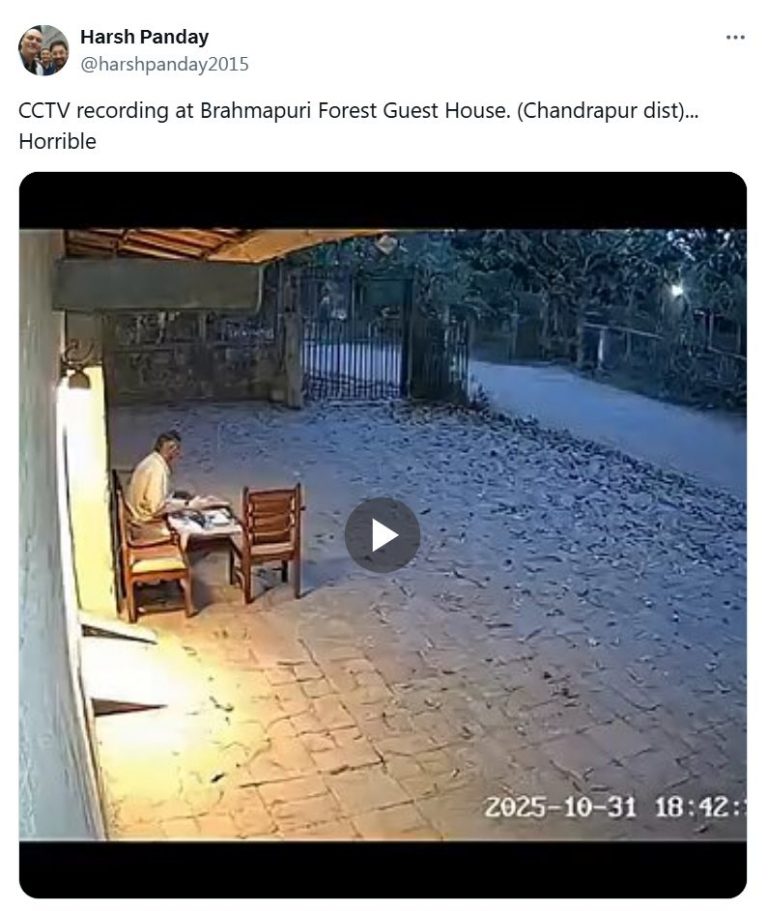

इसी तरह की एक घटना नवंबर में हुई जब 15-सेकंड की एक क्लिप बहुत ज़्यादा वायरल हुई जो एक CCTV फुटेज की तरह दिख रही थी. इसमें एक बाघ एक आदमी पर हमला करके उसे घसीटकर ले जा रहा था. यूज़र्स ने दावा किया कि ये महाराष्ट्र के चंद्रपुर ज़िले के ब्रह्मपुरी की घटना है. ऑल्ट न्यूज़ के व्हाट्सऐप हेल्पलाइन नंबर पर वीडियो को वेरिफ़ाई करने के लिए कई रिक्वेस्ट मिलीं.

हमारे फैक्ट चेक में पुष्टि हुई कि ये AI से बनाया गया था. फिर से, वीडियो की बारीकी से जांच करने पर कई कमियां सामने आईं, लेकिन बहुत से लोग इन कमियों को पहचान नहीं पाए या AI के अजीब आकर्षण में फंस गए.

‘ये डीपफ़ेक है!’: AI पर झूठा आरोप

AI का एक और खास इस्तेमाल तब सामने आया जब जानी-मानी हस्तियों ने इसे एक आसान कवर के तौर पर इस्तेमाल करना शुरू कर दिया. उदाहरण के लिए, जब नेशनल सिक्योरिटी एडवाइजर अजीत डोभाल की एक पुरानी क्लिप सोशल मीडिया पर वायरल हुई, जिसमें उन्हें ये कहते हुए दिखाया गया था कि पाकिस्तान की ISI ने भारत में इंटेलिजेंस के कामों के लिए मुसलमानों के मुकाबले ज़्यादा हिंदुओं को भर्ती किया था. डोभाल ने तुरंत दावा किया कि ये वीडियो डीपफ़ेक है. उन्होंने CNN-न्यूज़18 को एक्सक्लूसिव इंटरव्यू दिया, जिसे बाद में मनीकंट्रोल जैसे दूसरे आउटलेट्स ने भी चलाया.

हालांकि, ऑल्ट न्यूज़ ने उस फ़ुटेज का पता लगाया और पाया कि ये 2014 में ऑस्ट्रेलिया इंडिया इंस्टीट्यूट में डोभाल के दिए गए एक लेक्चर का है, जहां उन्होंने पूरे संदर्भ में ये बयान दिया था. उन्होंने ISI की भर्ती के ऐतिहासिक आंकड़ों पर चर्चा की थी और ये आग्रह किया था कि आतंकवाद को सांप्रदायिक नज़रिए से नहीं देखा जाना चाहिए. ये वीडियो असल में डीपफ़ेक टेक्नोलॉजी के बड़े पैमाने पर आने से पहले का है, इसलिए इसके AI-जेनरेटेड होने की संभावना बहुत कम है.

राजस्थान पुलिस भी मुश्किल में पड़ गई जब यूट्यूबर एल्विश यादव ने “राजस्थान में फ़ुल प्रोटोकॉल” नाम से एक व्लॉग पोस्ट किया. उसने दावा किया कि जयपुर में एक म्यूज़िक वीडियो शूट के दौरान राजस्थान पुलिस की गाड़ियों ने उसे एस्कॉर्ट किया और उसके काफिले की मदद की. फ़ुटेज में उसकी कार के आगे पुलिस की गाड़ियां दिख रही हैं और टोल पेमेंट से बचने जैसी हरकतें भी दिख रही हैं जिससे पुलिस की भूमिका पर सवाल उठे.

वीडियो वायरल होने के बाद, जयपुर पुलिस ने कोई भी एस्कॉर्ट देने से इनकार किया और दावा किया कि वीडियो “AI से एडिट किया गया” था और इसलिए गुमराह करने वाला था. पुलिस ने एल्विश यादव के खिलाफ एक साइबर पुलिस स्टेशन में FIR भी दर्ज की जिसमें उस पर राजस्थान पुलिस की बदनामी करने का आरोप लगाया गया. जयपुर पुलिस कमिश्नर बीजू जॉर्ज जोसेफ़ और एडिशनल कमिश्नर रामेश्वर सिंह सहित अधिकारियों ने ज़ोर देकर कहा कि कोई आधिकारिक एस्कॉर्ट नहीं दिया गया था.

ऑल्ट न्यूज़ ने पाया कि एल्विश यादव के व्लॉग में ही पुलिस की गाड़ियां दिख रही हैं और पुलिस ने अपने इनकार को साबित करने के लिए कोई सबूत नहीं दिया जिससे उनके दावों और FIR के पीछे की मंशा पर शक होता है.

अब लग रहा है चलो प्रेमचंद बैरवा तो सिस्टम में रहते हुए मीडिया ट्रायल की चपेट चढ़े, यहां तो पूर्व लगने के बाद भी थाने दर थाने जिप्सियां बदली जा रही हैं…! आम आदमी सोच रहा होगा ये मामला है क्या गुरु? https://t.co/yFSZxBXpZJ

— Avdhesh Pareek (@Zinda_Avdhesh) February 10, 2025

AI मैनिपुलेशन के खिलाफ आपका बचाव क्या है?

जहां तक ग़लत इरादों के साथ AI और डीपफ़ेक के इस्तेमाल की बात है, ये पूरी तरह साफ होता जा रहा है कि हम बहुत खतरनाक समय की ओर आगे बढ़ रहे हैं. 2026 में कुछ राज्यों के चुनाव होने वाले हैं. ऐसे में जेनरेटिव AI, अब सिर्फ एक टूल नहीं रहा; ये एक ऐसा हथियार बन गया है जो लोगों की सोच को एक तरह से बदल सकता है जिसका मुकाबला सिर्फ एक फ़ैक्ट-चेक से नहीं किया जा सकता.

जब हम दो बातों पर विचार करते हैं तो ये समस्या और भी कंप्लीकेटेड हो जाती है. पहली, टेक्नोलॉजी बहुत तेज़ी से बेहतर हो रही है. डीपफ़ेक में जो कमियां, मान लीजिए, तीन महीने पहले आम तौर पर दिखती थीं, वे अब नहीं हैं. और दूसरी बात, AI-डिटेक्शन टूल्स पूरी तरह से फूलप्रूफ़ नहीं हैं और उन्हें हमेशा बड़े फोरेंसिक और कॉन्टेक्स्टुअल सबूतों के साथ क्रॉस-चेक किया जाना चाहिए. ऑल्ट न्यूज़ में, हमारे काम ने लगातार ये दिखाया है.

तो फिर प्रॉपगेंडा का मुकाबला कैसे करें जब वो दुख और गुस्से की आड़ में छिपा हो? जब RG Kar पीड़ित की इमेज को डीपफ़ेक वीडियो में बदलकर पॉलिटिकल स्टोरीज बनाई जाती हैं, या जब AI से बनाई गई एक क्लिप एक टोपी पहने आदमी को गंदे पानी से खाना बनाते हुए दिखाता है ताकि सांप्रदायिक नफरत फैलाई जा सके, तो मकसद सच्चाई नहीं, बल्कि उकसाना होता है. जेनरेटिव AI को सच्चाई के आम होने की ज़रूरत नहीं है; उसे सिर्फ़ पूर्वाग्रह के परिचित होने की ज़रूरत है. इस मायने में ये हर प्रॉपगेंडा करने वाले की कल्पना को पूरा करता है, ठीक वही चीज़ विज़ुअल्स में दिखाता है जो वो दर्शकों से मनवाना चाहते हैं.

तो हम, एक समाज के तौर पर, इसका मुकाबला कैसे करें? इसका जवाब कुछ बहुत कम मुश्किल, लेकिन कहीं ज़्यादा ज़रूरी चीज़ में है: कॉमन सेंस, क्रिटिकल थिंकिंग और संयम. “इंटरनेट पर जो कुछ भी देखते हैं, उस पर विश्वास न करें”. इस समय शायद घिसा-पिटा लगे, लेकिन ये हमारी सबसे मज़बूत सुरक्षा है. रिवर्स इमेज सर्च और AI डिटेक्टर से परे एक इन्फॉर्मेशन इकोसिस्टम है जो तेज़ी से बदल रहा है. हम बस इतना कर सकते हैं कि सतर्क रहें जो हम देखते हैं उस पर सवाल उठाएं और सिर्फ़ इसलिए किसी चीज़ पर विश्वास करने की इच्छा को रोकें क्योंकि वो असली दिखती है. AI के ज़माने में, सतर्कता और डिजिटल साक्षरता अब ऑप्शनल नहीं हैं; वे ज़रूरी जीवन कौशल हैं.

सत्ता को आईना दिखाने वाली पत्रकारिता का कॉरपोरेट और राजनीति, दोनों के नियंत्रण से मुक्त होना बुनियादी ज़रूरत है. और ये तभी संभव है जब जनता ऐसी पत्रकारिता का हर मोड़ पर साथ दे. फ़ेक न्यूज़ और ग़लत जानकारियों के खिलाफ़ इस लड़ाई में हमारी मदद करें. नीचे दिए गए बटन पर क्लिक कर ऑल्ट न्यूज़ को डोनेट करें.

बैंक ट्रांसफ़र / चेक / DD के माध्यम से डोनेट करने सम्बंधित जानकारी के लिए यहां क्लिक करें.